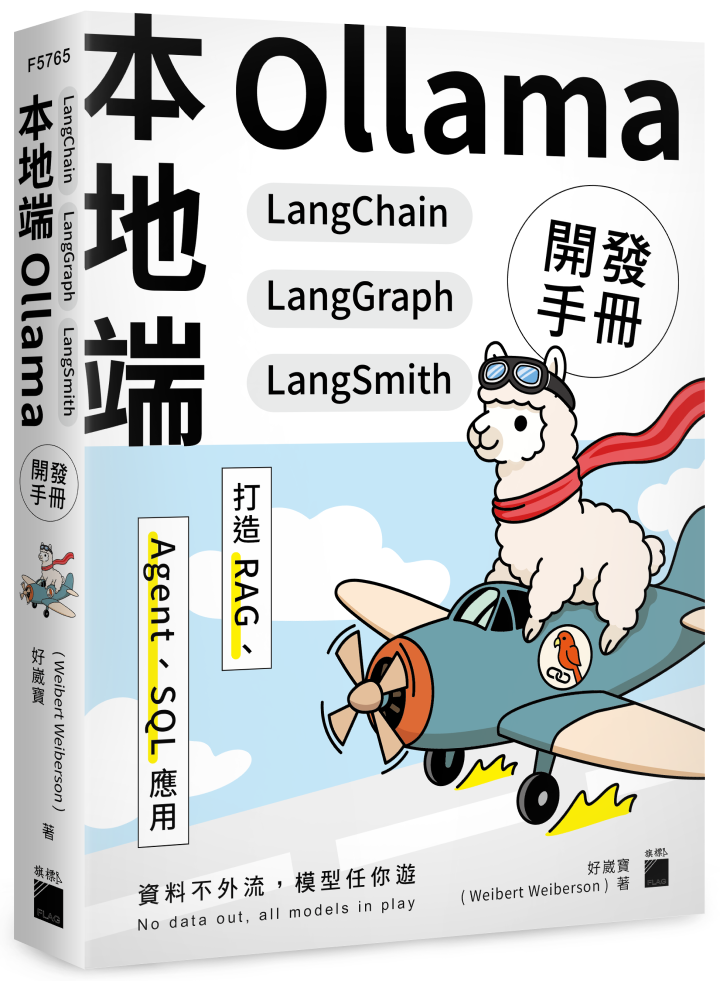

崴寶出書了 - 本地端 Ollama × LangChain × LangGraph × LangSmith 開發手冊:打造 RAG、Agent、SQL 應用

日期:2025-08-25

本書是專為考量資料隱私問題但又想開發結合大型語言模型 LLM 應用者所設計,不倚賴大型 AI 公司的雲端服務,利用 Ollama 系統建置本機 LLM 推論引擎,既保護隱私又節省串接大型 AI 公司 API 服務的費用。

書名:《本地端 Ollama × LangChain × LangGraph × LangSmith 開發手冊:打造 RAG、Agent、SQL 應用》

筆名:好崴寶(Weibert Weiberson)

這本書的誕生,其實來自一個想法:

「如果有免費的本地端 LLM(大型語言模型),為什麼學習 LangChain 就一定要綁 OpenAI 呢?」

寫書契機:

在研究過程中,崴寶發現市面上幾乎所有關於 LangChain 的書籍,都跟 OpenAI 綁定,實作時幾乎都需要串接付費 API。這對於剛入門的朋友、學生,甚至資源有限的開發者而言,無疑是一大門檻。

而當崴寶發現 Ollama 支援免費本地模型,心中立刻浮現:「如果把 Ollama、LangChain、LangGraph、LangSmith 整合在一起,感覺會超級幸福孟」的想法,埋下了崴寶想撰寫這本書的種子。

在開始撰寫之前,崴寶有先在各大書店搜尋,卻找不到任何結合 Ollama × LangChain 的教學書,更別說提到 LangGraph、LangSmith 的整合實作。這讓崴寶更加確信:這是一條還沒人走過、卻非常值得分享的路。

書的核心理念:

即使是中小型的本地模型,只要是高精度版本,模型大小依然對硬體資源有一定要求。為了讓更多人能實際參與 LLM 開發,崴寶決定讓這本書以模型量化為核心技術主軸,降低進入門檻。

這本書:

- 完全基於 Ollama 執行模型

- 不依賴 OpenAI API

- 對於有強大 GPU 的開發者,也保有不量化模型的彈性

- 未來如果 Ollama 上架更多模型,你也能輕鬆整合到本書的實作中

這本書是寫給想學習大型語言模型(LLM)應用開發的讀者,會涵蓋像是 LangChain、Ollama、LangGraph、LangSmith 的整合實作。

線上購買連結:

除了以上書局外,其他各大書局也可以買的到呦!!

喜歡 好崴寶 Weibert Weiberson 的文章嗎?在這裡留下你的評論!本留言區支援 Markdown 語法。